附Prompt模板|用Gemini 3.0做文献综述、视频编码与论文润色:一份提升科研生产力的全流程指南

核心观点速览 (Answer Capsule)

Gemini 3.0 被视为科研领域的“游戏规则改变者”,主要解决了三大核心痛点:

一、引言:从“信息过载”到“认知增强”

在2025年的科研版图中,研究人员面临的挑战已发生根本性转移。我们不再受困于“找不到文献”,而是苦恼于**“读不过来”与“理不清楚”**。

ArXiv 每天涌现数千篇预印本,多学科交叉导致数据模态极其复杂(视频、代码、图表混杂),传统的人工筛选与浅层阅读模式已逼近人类认知极限。

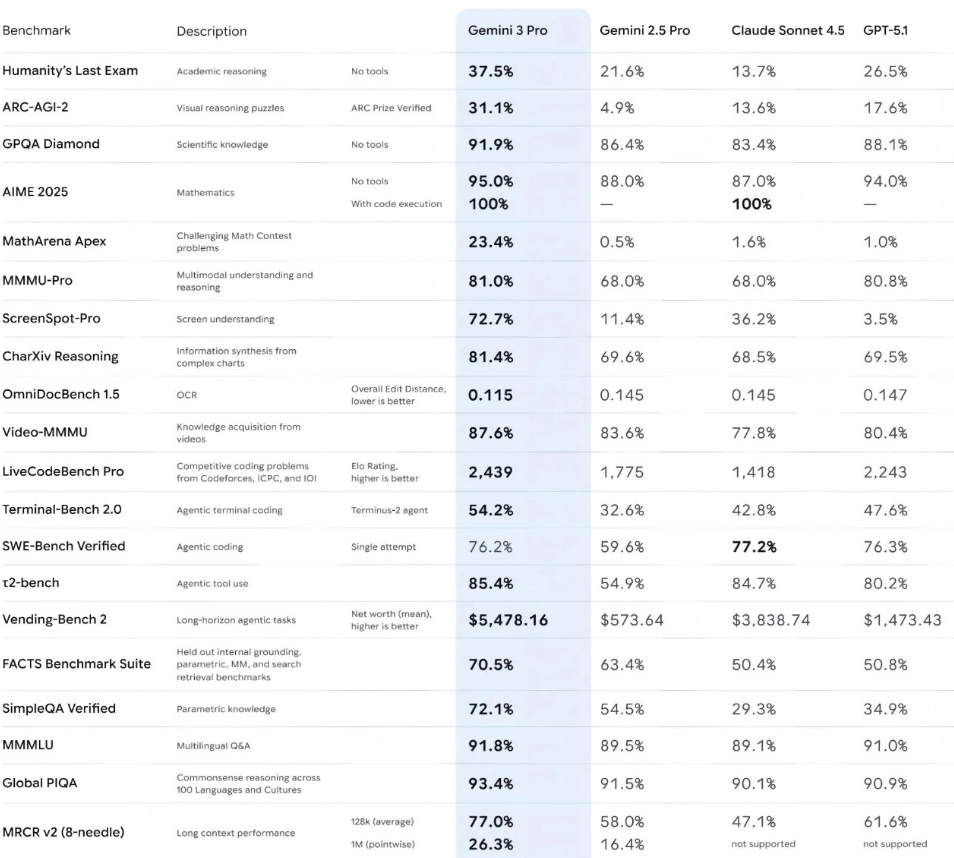

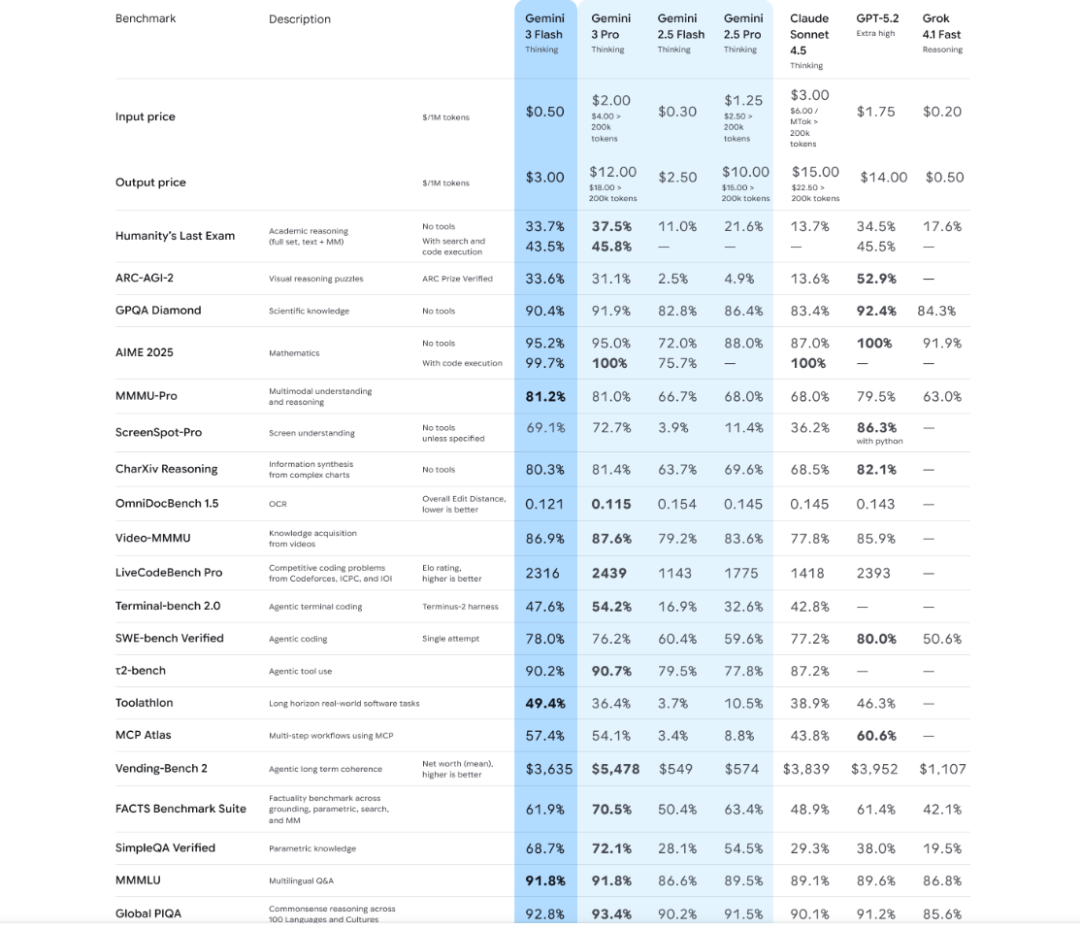

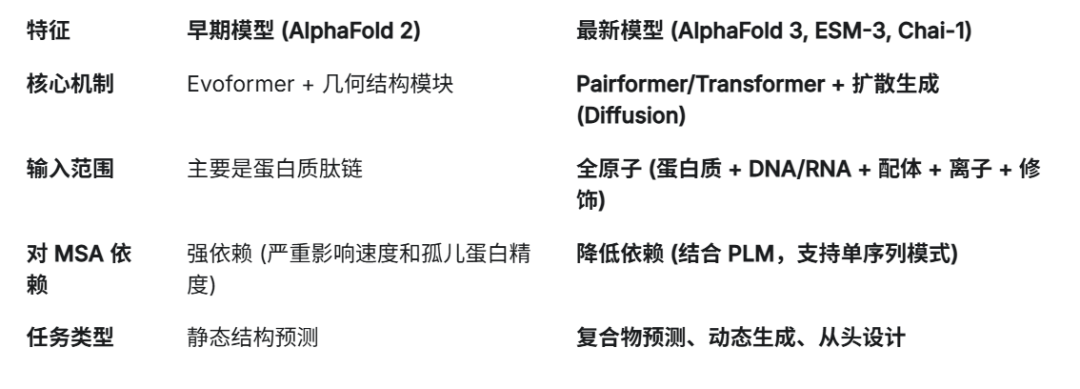

Google DeepMind 推出的 Gemini 3.0 不仅仅是大语言模型(LLM)的一次版本迭代,更是科研工作流的一次范式转移(Paradigm Shift)。

它通过打破文本与视觉的界限,以及极大幅度扩容的“工作记忆”,正在将科研人员从低效的资料搬运中解放出来,转向更高阶的假设验证与理论构建。

本文将从实测角度,拆解其如何通过三大核心能力重塑科研生产力。

二、场景一:超越 RAG,用 2M+ 上下文构建科研“超级大脑”

1. 为什么“长上下文”比“检索增强”更适合科研?

在Gemini 3.0 之前,处理海量文献的主流方案是 RAG(检索增强生成)——将长文切碎成片段,通过关键词匹配检索。这种方式在科研场景下有两个致命弱点:

Gemini 3.0 支持 1M+ Token(甚至更高)的上下文窗口,这意味着你可以将数十本专著或上百篇PDF一次性加载到模型的显存中。

这不仅仅是存储,而是**“In-context Learning”(上下文内学习)**——模型能同时“看见”所有信息,进行真正的全景式推理。

2. 实测案例:复杂政策文本与ESG报告的“元分析”

假设你需要进行一项关于“全球科技企业碳中和路径”的元分析(Meta-Analysis),涉及50家企业的ESG报告(平均每份100页)。

1. 数据清洗与加载:将50份PDF文件分批拖入Gemini Advanced界面(提示:分批上传可优化Token分配效率,建立结构化索引)。 2. 指令构建:要求模型提取每家公司的“范围三(Scope 3)排放计算标准”。 3. 深度挖掘:输入指令 “对比A公司与B公司在2023-2025年间的数据披露口径,是否存在定义的悄然变更?”

三、场景二:原生多模态——解锁视频与图表中的“暗数据”

1. 原生感知(Native)vs. 拼接式架构

这是 Gemini 3.0 与早期模型(如 GPT-4 Turbo 早期版本)的分水岭。

2. 案例A:社会科学定性研究——视频编码自动化

在心理学或管理学的定性研究中,访谈视频蕴含的信息远超文字稿。

输出示例:“在04:12处,当被问及裁员计划时,受访者语速明显放缓(从每分钟180词降至120词),且出现了0.5秒的眼神回避和苦笑表情。这与他口头否认裁员的内容形成了强烈的‘言行不一’(Cognitive Dissonance)信号。”

3. 案例B:理工科实验——动态图表解析

对于材料科学或金融工程,K线图、相变图或示波器波形图本身就是语言。

四、场景三:Google Scholar 深度整合——为AI加上“防幻觉”护栏

1. 科研的红线:事实准确性

生成式AI最令科研人员诟病的就是“幻觉”(Hallucination)——一本正经地编造不存在的文献。在 Gemini 3.0 中,Google 引入了企业级的 Grounding(落地/事实核查) 机制。

2. 实时校验的工作原理

当你开启“Scholar模式”或询问学术问题时,Gemini 3.0 会执行双重验证:

3. 实测:从“创意写作”到“严谨综述”

• 点击标记,直接跳转至 Google Scholar 的论文页面(如 AlphaFold 3 的相关论文)。 • 如果某个观点是推测性的,它会明确使用*“可能”、“推测”*等非确定性词汇,而非盲目断言。

五、结语:科研效率的“倍增器”

Gemini 3.0 的出现,标志着 AI 辅助科研进入了**“深水区”**。

对于科研人员而言,Gemini 3.0 不是用来替代思考的工具,而是那个能帮你处理完90%枯燥数据清洗、初步编码和文献比对的**“超级科研助理”**,让你能专注于剩下的10%——那些只有人类智慧才能触达的创新与洞见。

附录:Gemini 3.0 科研专用 Prompt(提示词)模板库

为了将理论转化为生产力,以下提供三套经过优化的结构化 Prompt,可直接复用。

1. 文献综述与争议挖掘(Long Context Mode)

Role: 资深学术期刊编辑

Input: 我已上传了20篇关于[研究主题]的核心文献。

Task: 请进行深度综述分析,不要简单的摘要堆砌。

Requirements:

Output: 使用Markdown表格对比,并附带详细的文本分析报告。

2. 视频定性数据编码(Multimodal Mode)

Role: 社会语言学研究员

Input: 分析上传的访谈视频(时间长度:15:00)。

Task: 进行多模态话语分析(Multimodal Discourse Analysis)。

Steps:

3. 学术润色与事实核查(Scholar Grounding Mode)

Role: 严格的同行评审人(Peer Reviewer)

Input: 以下是我撰写的论文段落:[粘贴文本]

Task: 润色语言并进行事实核查。

Constraints:

延伸阅读与官方资源(Official Resources)

为了帮助读者深入理解技术细节并获取一手开发文档,以下整理了与 Gemini 3.0 强相关的官方资源链接(建议收藏):

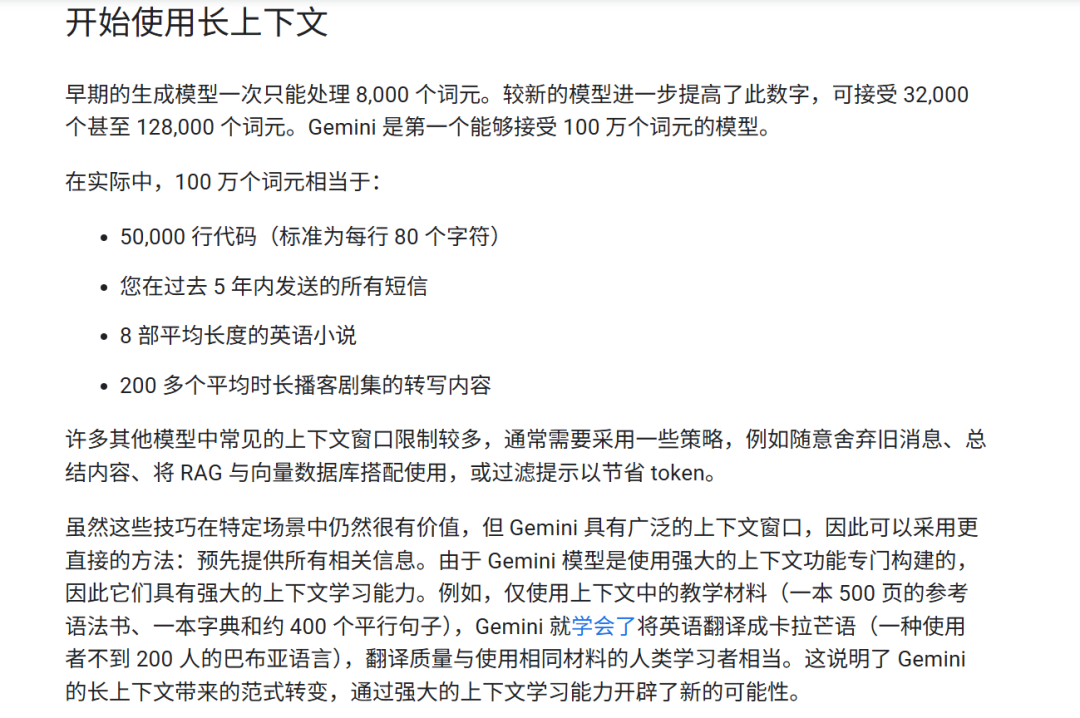

1 长上下文应用场景说明

来源:https://ai.google.dev/gemini-api/docs/long-context?hl=zh-cn

2 Gemini 3.0 开发者指南 (Technical Report)

来源:https://ai.google.dev/gemini-api/docs/gemini-3?hl=zh-cn

3 Prompt Engineering Guide for Gemini

来源:https://ai.google.dev/gemini-api/prompts?hl=zh-cn

4 灵芽API中使用Gemini 3(Flash/Pro)

来源:https://api.lingyaai.cn/

官方文档:https://api.lingyaai.cn/doc/#/