Anthropic Opus 4.5:三大更新让 AI 智能体像操作系统一样高效调度工具

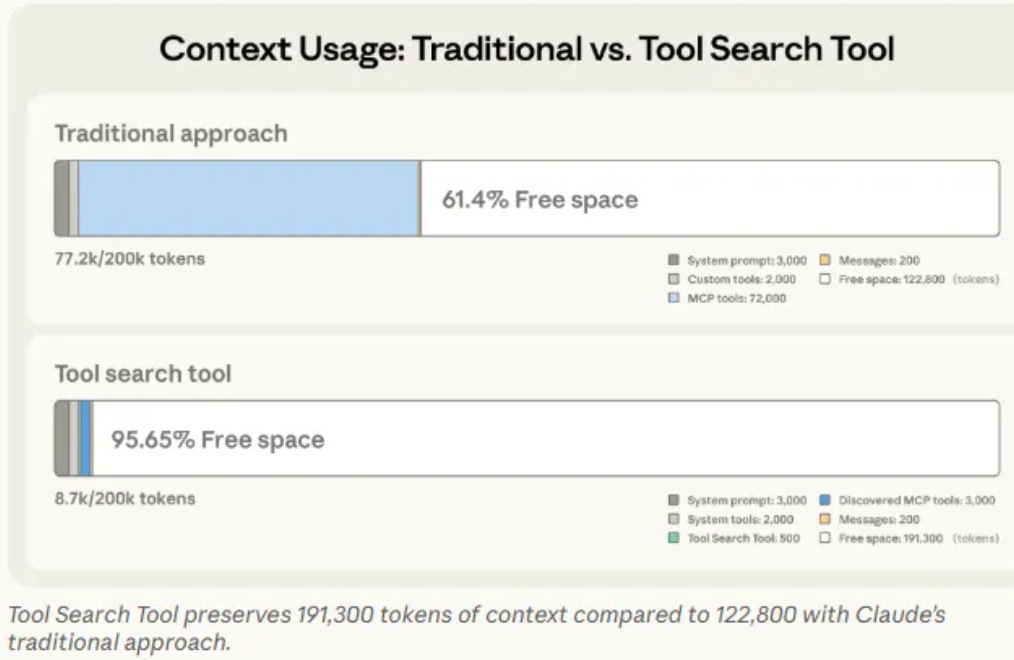

过去一年,许多企业在将 AI 智能体投入生产环境时,反复遇到三类典型问题:任务卡住不动、工具调用搞错事、上下文被大量工具信息撑爆。 这些现象的背后,是一个并不新鲜但一直被低估的事实——大模型在使用工具方面的能力仍然非常原始。 近期,Anthropic 在发布 Opus 4.5 的同时,带来了三项核心更新,让 Claude 的表现更接近“操作系统级助手”,而不仅仅是一个会话型 AI。 这三项更新分别是:按需发现的工具搜索、用代码编排的程序化工具调用、以及通过示例学习的工具使用能力。 这些变化指向一个重要趋势——未来 AI 的真正竞争力,不在单纯的模型本体,而在于“模型 × 工具 × 运行时”的整体能力。 在企业环境中,AI 系统往往连接几十甚至上百个 MCP 工具,比如 GitHub、Slack、Jira 等。 这些工具的定义文件通常体积庞大(JSON Schema),光是加载就可能消耗成千上万的 token。 工具数量带来了一系列连锁问题: • 大量工具定义挤占上下文空间,导致模型失去关键信息。 • 名字相似的工具容易被误选,增加调用错误率。 • 多次往返的工具调用让任务延迟高、错误率累积。 • Schema 只告诉结构,却不告诉使用惯例,模型只能猜测参数填法。 过往,工具预加载会消耗巨大上下文空间。例如几十个工具组合,可能占用 55K–134K tokens,这让模型在关键任务上反应迟缓或选错工具。 Opus 4.5 引入了按需加载机制:只保留工具索引,在真正需要时通过“工具搜索工具”动态找到并加载匹配的工具,API 中的 这一机制使 token 开销最多可减少 85%,上下文保留率可达 95%,工具选择准确率也显著提升。 它特别适用于大型工具库、定义庞大且名称易混淆的场景,相当于在 AI 工具系统中引入了类似动态链接库的思想。 传统的多工具任务常因上下文污染和多轮推理的延迟而表现不佳。新的程序化工具调用让 Claude 直接用代码(如 Python)编排任务逻辑,包括条件判断、循环、数据转换和异常处理,不再依赖自然语言推理。 比如,检测一个季度的差旅预算,可以并行调用多个费用查询工具,最终只返回超支名单,而不是把全部明细硬塞到上下文。 这意味着 AI 从“自然语言驱动”过渡到“可控、可测试的工程模式”,稳定性显著提高。 Schema 定义了字段,但没告诉模型如何真正最好地调用 API。新的机制允许在工具定义中直接附上“最佳实践”示例调用,让模型从有限样例中快速掌握参数习惯、格式要求、字段关联等。 这类示例尤其适用于企业内部复杂 API,可将工具使用准确率由约 72% 提升到 90%,让 AI 像人类新人一样“看例子就会用”,减少凭空猜测的风险。 这三项机制的结合,带来几方面关键改变: • 从上下文受限走向海量可扩展——工具数量再多也不会拖慢智能体。 • 智能体更像操作系统进程,负责调度资源和执行任务。 • 程序化流程让多步骤任务可控、可测试、可复现。 • 模型能依靠经验示例快速适应企业内部工具规范。 回顾时间线变化:2023 是 ChatGPT 的普及年,2024 进入 Agent 试验期,而 2025–2026 将是“工具 × AI 操作系统”的关键阶段。 核心认知正在转变——AI 的生产力优势更多取决于工具调度能力,而非单一模型的规模。 在复杂度高、规模大的场景下,比如 AI IDE、企业运营助手、企业级 Agent 和流程自动化系统,工具爆炸和上下文管理将是必须解决的问题,而 Opus 4.5 的三项能力正好提供了解决方案。 它预示了一种新范式:模型不再是故事的主角,工具系统才是;智能体是运行时调度器,而不仅是聊天助手;API 是可调度能力单元,而不是单纯接口。 可以预期,未来更多模型厂商会跟进这一方向,让 AI 与工具的协作能力成为竞争焦点。AI 工具时代的变局:从卡顿到操作系统级智能体

引入与核心问题提出

痛点剖析:工具爆炸时代的智能体困境

这些限制直接压缩了智能体的生产力——在实际业务场景下,这意味着系统效率低、维护难度大、出错频率高。

这些限制直接压缩了智能体的生产力——在实际业务场景下,这意味着系统效率低、维护难度大、出错频率高。三项能力更新的详细拆解

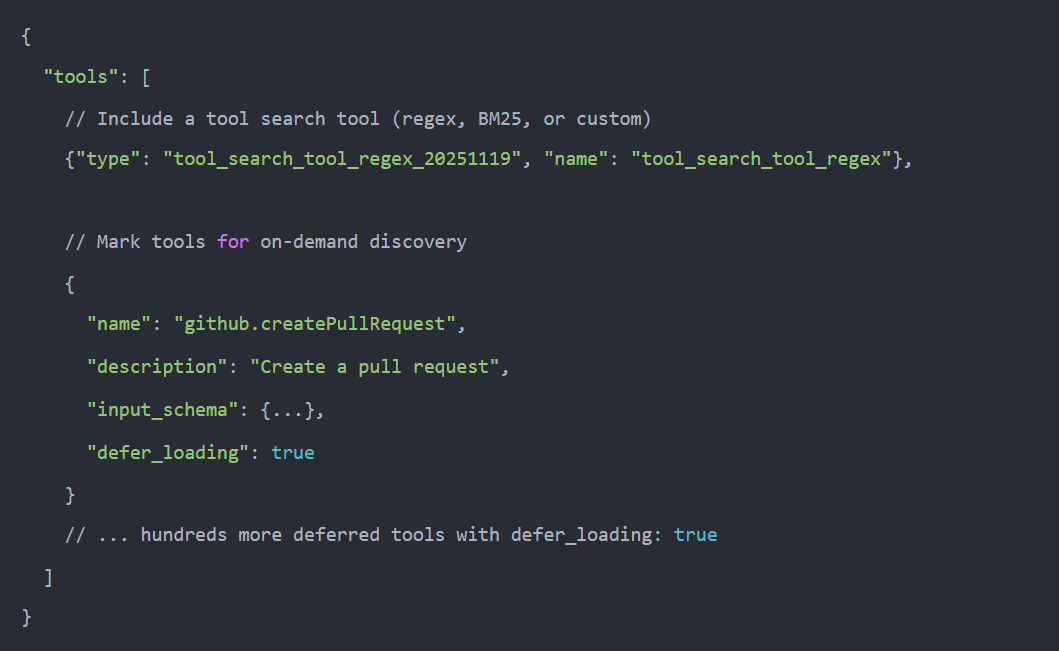

工具搜索:按需加载、动态发现工具

defer_loading: true 参数就是关键。

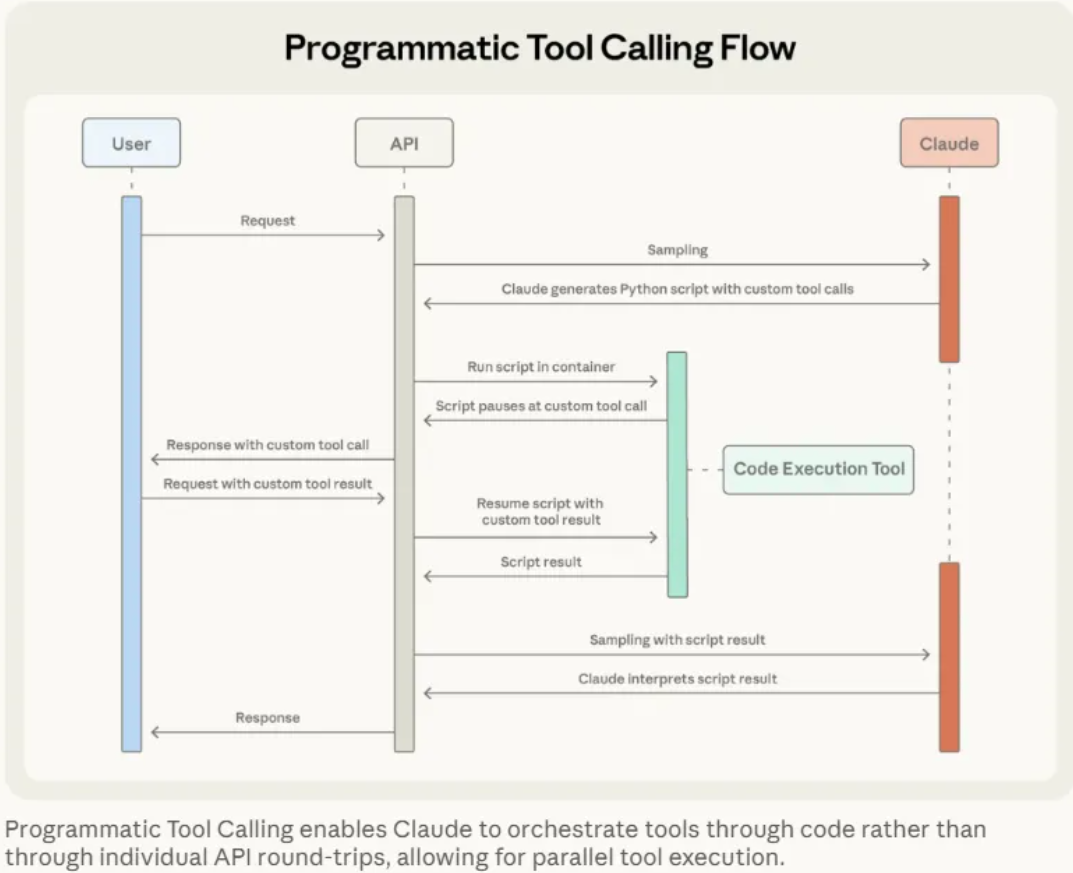

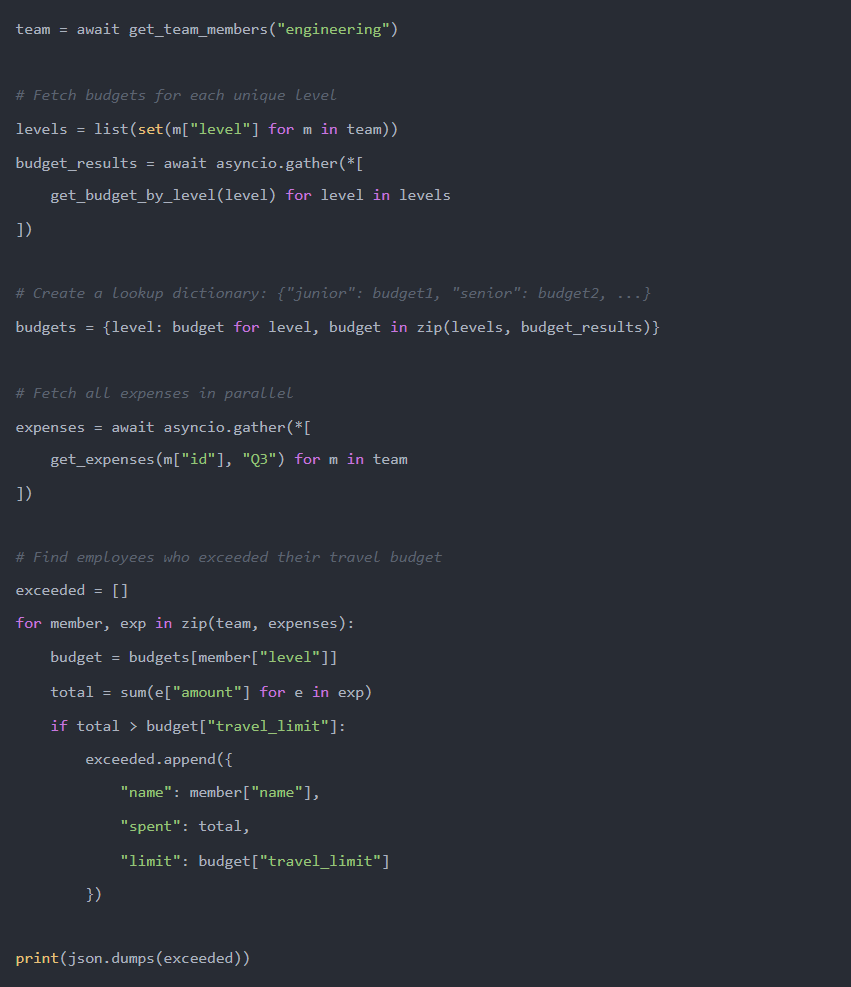

程序化工具调用:用代码编排多工具任务

中间结果会在执行层处理,而不是塞进上下文,从而减少约 37% 的 token 消耗,同时降低延迟、提升准确率。

工具使用示例:让模型学会最佳实践而非猜测

更新的整体意义与范式变化

行业趋势与未来预测