终于,NotebookLM 和 Gemini 合体了。这是什么神之更新?

最近,NotebookLM 和 Gemini 之间多了一条看起来很小、实际很关键的通道:Gemini 网页端(Pro 会员)可以直接导入 NotebookLM 的笔记本。

当你第一次点开这个入口,可能只会觉得“哦,又多了个可以喂文件的地方”;但如果往深一点看,这其实是在悄悄改变我们和“私域知识”打交道的方式。

这不是两个产品的简单串联,而是“知识管理工具 + 全能 AI 助手”的一次互相补位:NotebookLM 负责把你的资料变成结构化、可计算的“知识工程”;

Gemini 则把阅读、分析、编码、画图、深度搜索这些通用能力铺在这层基础之上——从经典的“检索后回答”,迈向“能自己规划检索和决策”的 Agentic RAG。

下面就按几个部分,拆开来说。

一、新功能速览:Gemini 可以直接用你的 NotebookLM 知识库了

先看表面发生了什么。

在 Gemini Web 端,如果你是 Pro 会员,现在可以在聊天界面里看到一个新入口:

除了上传文件、贴链接之外,多了“从 NotebookLM 导入”的选项。点进去,你能直接选择自己在 NotebookLM 中的某个笔记本,勾选后,这个笔记本就成了当前对话的“知识背景”。

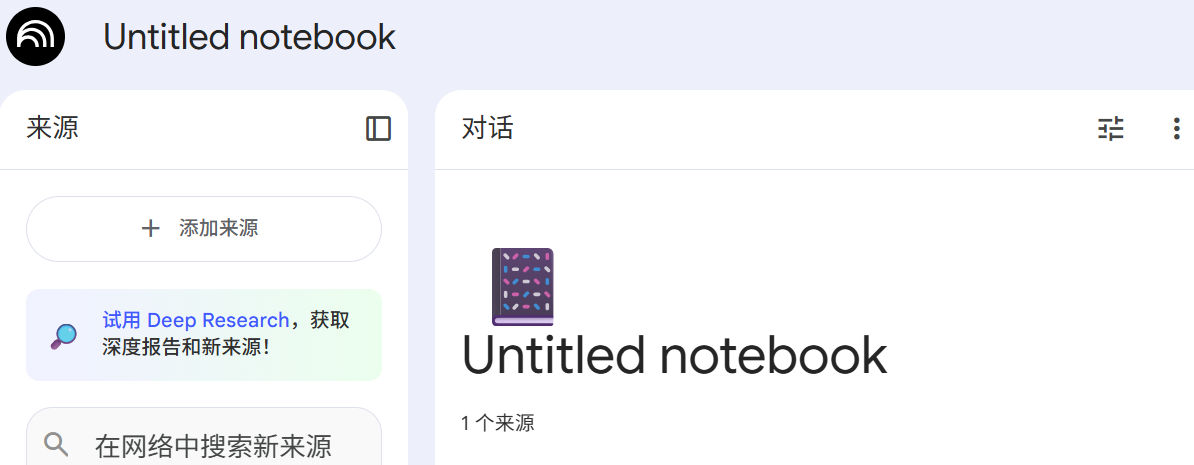

从操作路径上看,就是三件事:

1. 在 NotebookLM 中,你已经有一个或多个笔记本,里面是文档、网页、PDF 等资料;

2. 在 Gemini 中发起聊天,点击“添加内容”,选择“NotebookLM 笔记本”;

3. Gemini 会在回答你的问题时,将这个笔记本视作权威数据源之一。

表面上,它和“给模型喂一堆 PDF”没什么两样。区别在于:

• 你导入的不是一堆散文件,而是 NotebookLM 已经做过“结构化处理”的知识集合;

• 这个集合在 NotebookLM 那边,可以继续更新、重组、扩展,Gemini 这边则像是外接了一块专用“硬盘”。

这一步,为后面更复杂的玩法打了基础。

二、合体之后能做什么?几个典型场景

1. 把多个“知识孤岛”合并起来问

NotebookLM 自己有一个很大的限制:不同笔记本之间不能直接互通。你做了一个“AI 历史”,又做了一个“某位专家的文章集”,再做了一个“会议记录”,它们在 NotebookLM 里是三座孤岛。

有了 Gemini 的导入能力,你可以:

• 在 NotebookLM 中分别维护这些笔记本;

• 到 Gemini 里,开启一个新对话;

• 同时导入多个笔记本,让 Gemini 在一个问题里跨本对照。

比如,你可以让 Gemini:

“结合我这个‘Karpathy 文章集’和‘大模型发展时间线’两个笔记本,整理出一份他认知变化与技术演进的对照表。”

NotebookLM 做不到的“跨本思考”,现在可以在 Gemini 这边自然完成。

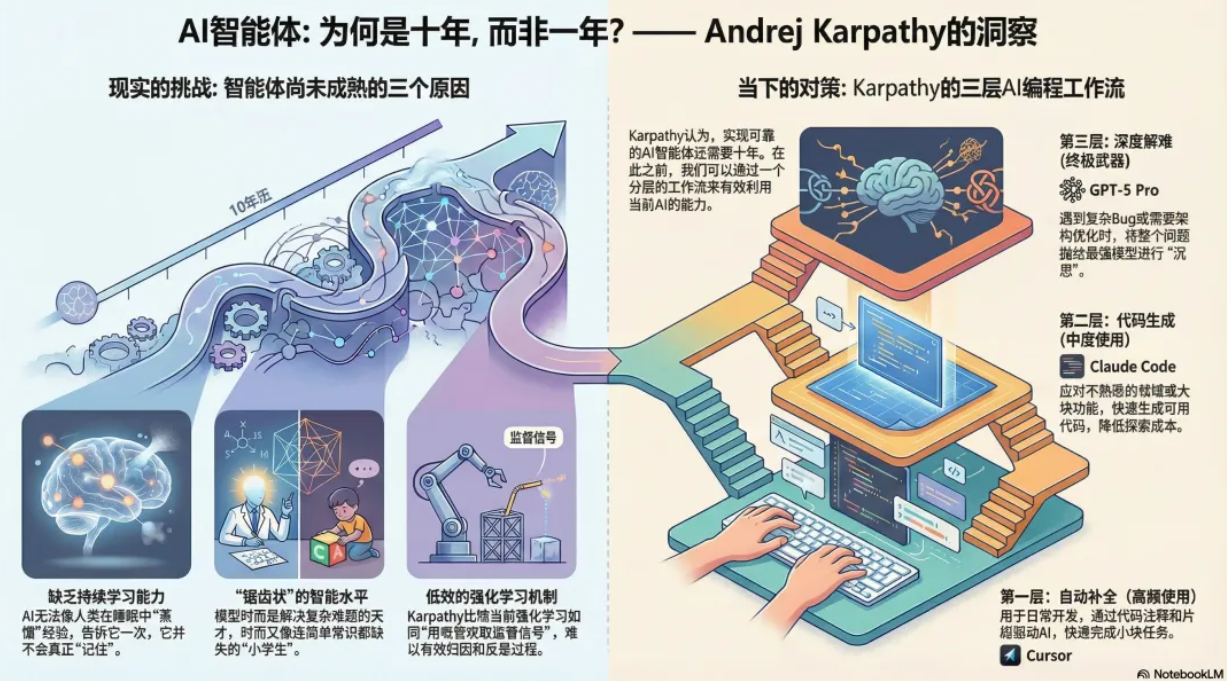

2. 跨源生成可视化信息图

很多人做研究,最后会遇到一个问题:文字总结有了,但要给别人一眼看明白,就得做图。

传统做法是:自己打开画图工具一点点画。现在可以尝试的是:

1. 在 NotebookLM 中整理好某个主题笔记本,例如“某位研究者的观点演变”;

2. 在 Gemini 中导入这个笔记本;

3. 让 Gemini 先生成结构化描述,比如“按时间排序的关键观点列表”;

4. 接着让它输出可视化方案(比如用 Mermaid 或者可以导入常见画图软件的格式);

5. 再把这些结构贴到你熟悉的工具中微调。

比如,可以直接问:

“基于我的这个 NotebookLM,列出一个‘Karpathy 对 AI 的认知变迁’的阶段划分,然后给出一份可用于绘制时间轴信息图的结构化描述。”

你得到的,不再只是长篇文字,而是能一步步落地为可视化的“蓝本”。

3. 和 Deep Research 结合做系统性研究

Gemini 的 Deep Research 侧重于“主动搜集公开信息、自动查证、反复迭代答案”。但它对你的个人资料是不了解的。

导入 NotebookLM 后,就能把这两块拼到一起:

• NotebookLM 提供“你的私域知识”:读书笔记、课程记录、项目文档等;

• Deep Research 帮你在公开世界查“外延”,比如最新论文、新闻、其他观点。

你可以发起这样的问题:

“先基于我的 NotebookLM 中这本关于 Agentic RAG 的笔记,梳理核心概念;再用 Deep Research 的能力查找近两年的相关公开研究,对比其中的异同。”

这本质上是在搭一个“你自己的知识 + 外部世界”的联合研究台。

4. 利用代码、图像、多模态能力做“工程化输出”

NotebookLM 对代码、图像、视频的处理能力相对有限。而 Gemini 的长处恰好在于:

• 能写代码、改代码、解释代码;

• 能理解图片、帮你画草图、生成图像描述;

• 支持多轮推敲、把结论固化为工具或脚本。

举个常见的工程化场景:

1. 你把一系列学习笔记整理在 NotebookLM(例如某个框架的最佳实践);

2. 在 Gemini 中导入这些笔记本;

3. 让它根据笔记内容生成脚本、CLI 工具或小 Web 页面;

4. 再和它多轮讨论,在你的真实项目环境中不断修正。

这里 NotebookLM 像是保存了“你的领域知识”,Gemini 则把这些知识变成“真正能跑起来的东西”。

三、“东厂和西厂”:各自负责什么?

如果用一个略带玩笑的比喻:NotebookLM 更像“东厂”,Gemini 更像“西厂”。两边都有权,都很厉害,但职责和风格完全不同。

NotebookLM:偏“东厂”的垂直知识工程

NotebookLM 的主战场是“私域知识工程化”:

• 它擅长处理成体系的资料:文档集、课程、一个长期项目的材料;

• 会帮助你做向量检索,把内容拆成片段,用语义相似度来匹配问题;

• 会鼓励你按主题建笔记本、分章节,将原始资料整理成更清晰的结构。

可以理解为:NotebookLM 帮你把一堆散乱的资料,变成一个可被模型稳定使用的“知识库”,并且尽量保持上下文连贯、引用准确。

Gemini:偏“西厂”的通用执行与发散能力

Gemini 则是一个广义的“全能 AI 助手”,能:

• 看网页、看图片、看视频;

• 写代码、改 bug、给出优化建议;

• 用 Deep Research 的方式,主动查外部信息,反复迭代答案;

• 按你的要求生成报告、演讲稿、图示草案等。

如果说 NotebookLM 是“知识后端工程”,那 Gemini 更像“前台业务执行”,负责所有和“交付结果”相关的环节。

合起来:NotebookLM 负责垂直深度,Gemini 负责横向扩展

两者联动之后的分工,大致是:

• NotebookLM 负责:把你关心的领域资料,整理得结构化、可查询、可引用;

• Gemini 负责:在多种媒介(文字、图、代码、图像等)上,把这些知识用出来。

从这个角度看,这次整合的意义不是“又多了个导入入口”,而是:

把一个擅长“深挖某个领域”的工具,接到了一个擅长“广泛执行任务”的助手上,让“深度”和“广度”叠加。

四、实战体验:好用,但远没到“神级”

说完优点,也要说不那么好用的地方。

1. Notebook 概念上的“理解偏差”

在真实使用中,很容易遇到一个问题:到底哪些东西该放到 NotebookLM?哪些该直接丢给 Gemini?

很多人会混淆:

• 把任何临时文件都建成一个笔记本;

• 或反过来,把本该长期维护的知识只当一次性附件丢进 Gemini。

久而久之,就会变成:

• NotebookLM 里一堆“半成品”笔记本,缺乏结构,难以长期复用;

• Gemini 这边的对话上下文混乱,难以重复利用之前的积累。

更理想的做法是:

• 把 NotebookLM 当成“需要长期维护的主题知识库”:比如某个研究方向、一个大型项目、个人知识体系;

• 把 Gemini 当成“使用这些知识完成具体任务的助手”:写一篇文章、生成一个可视化、做一次对外分享。

目前产品本身在引导用户这件事上做得还不够,导致上手时的理解偏差比较多。

2. 工程化专业度的差距

从工程视角看,NotebookLM 和 Gemini 在“结构化输出”“可控性”上还存在一些差异,比如:

• NotebookLM 的回答通常更“贴原文”,适合做引用和摘要;

• Gemini 的回答更善于发挥和重组,有时会离原文较远,需要你自己做核查;

• 在复杂任务上(比如需要明确步骤、可复现的链路),两者都还不算真正的“生产级工具”,更像“强辅助”。

一些媒体会用“神级更新”“彻底改变一切”之类的说法,但在实际使用中,你能明显感到:

• 这次整合是一个重要方向,但体验还在早期;

• 对于需要高置信度、高可控性的任务,仍然需要人工把关和二次加工。

五、从 RAG 到 Agentic RAG:真正的升级在幕后

表层看,是“导入笔记本”;底层看,其实是在慢慢靠近一个更高级的模式:Agentic RAG。

1. 传统 RAG:用户问、系统找、模型答

RAG(Retrieval-Augmented Generation)的经典流程可以总结成:

1. 用户提问;

2. 系统用向量检索在知识库里找相似片段;

3. 把这些片段和问题一起喂给模型;

4. 模型结合上下文生成答案。

它的特点是:

• 检索阶段基本是“被动”的:用户怎么问,就怎么找;

• 模型只在“生成阶段”起作用——负责把检索来的东西编织成自然语言。

优点:比纯“瞎编”更可靠,能多引用原文。缺点:对问题表述非常敏感,模型对“该怎么检索、要不要换个问法”没有太多自主性。

2. Agentic RAG:让模型介入“检索”和“决策”

Agentic RAG 的核心变化是:模型不再只作为一个回答机器,而是作为“决策代理”参与整个链路。

具体表现为:

• 它会根据你的问题,自己拆解出多个子问题;

• 会主动决定该从哪个知识源检索(NotebookLM 笔记本、外部网络、历史对话等);

• 会根据检索结果评估“信息是否够用”,必要时再发起新一轮检索;

• 会对多个中间答案做对比和自我修正,而不是一次过生成最终回复。

简化成一句话:

不再是“你问一次,它查一次,然后直接回答”,而是“它会自己规划‘查什么、查几轮、如何验证’”。

3. “墨问时间”案例:从“阅读+生成”到“决策+评估”

假设你有一个类似“墨问时间”这样的知识库:里面是你长期积累的读书笔记、访谈整理、技术文章摘录等。

在传统 RAG 模式下,你通常是这样使用它:

1. 提出问题:“帮我总结这几年关于 Agentic RAG 的主要思路”;

2. 系统在“墨问时间”里找相关内容;

3. 模型综合这些内容写一段总结。

在 Agentic RAG 模式下,理想的流程会更复杂一些:

1. 模型先根据你的问题拆解任务:

• 需要时间线;

• 需要不同团队的方案差异;

• 需要目前的共识和争议点。

2. 然后它会决定数据源:

• 先查“墨问时间”;

• 不够,再用 Deep Research 查公开资料;

3. 接着,它会对比两个来源:

• 看哪些观点在你的知识库里已覆盖;

• 哪些是外部新出现的;

4. 最后,它才生成答案,并在内部给出“置信评估”:

• 哪些是高度依赖你知识库的结论;

• 哪些来自外部不确定性较大的资料。

这个过程里,模型参与的不仅是“说什么”,更是“查什么、查到什么程度、怎么权衡不同来源”。

4. NotebookLM + Gemini:向 Agentic RAG 靠近的一小步

回到这次整合,它目前还远没达到完整的 Agentic RAG,但有几个重要前提已经具备:

• 私域知识有了规范载体:NotebookLM 笔记本;

• 通用智能代理有了统一入口:Gemini(加上 Deep Research);

• 模型可以在一次对话中,跨多个知识源调度信息。

接下来如果继续演进,可能会出现这样的使用方式:

• 你只描述目标:“帮我准备一场关于 Agentic RAG 的技术分享,面向新手开发者,包含案例和代码示例”;

• 模型在内部自动:

• 从你的 NotebookLM 找基础资料;

• 从外部查最新实践;

• 规划分享结构;

• 生成讲稿和 Demo 代码;

• 标出哪些部分需要你重点核查;

• 你更多做的,是最后的审核、取舍和润色,而不是在检索和整理上消耗大量时间。

这就是从“用户-检索-生成”走向“目标-决策-执行-评估”的路径。

六、总结:外挂 RAG、打通孤岛、让模型参与全链路

把视角拉回来,这次 NotebookLM 与 Gemini 的联动,可以归纳为三个关键价值点:

1. 外挂式 RAG

NotebookLM 笔记本成了 Gemini 的精准数据源,相当于给通用模型外挂了一个“可信知识库”,在不少场景里能显著压缩“胡乱发挥”的空间。2. 跨越知识孤岛

通过 Gemini,你可以在一次对话中调用多个 NotebookLM 笔记本,实现跨主题、跨项目的综合思考,部分缓解了 NotebookLM 内部笔记本彼此不通的问题。3. 让模型参与整个链路,而不是只负责最后几句话

这次整合虽然还不算成熟,但方向很明确:• 模型不只用来“写结论”;

• 还可以用来规划检索、选择数据源、进行中间评估。

这正是向 Agentic RAG 靠拢的必经之路。

当前的体验,还远称不上完美,交互上有误解空间,工程化细节也有不少槽点。但从“给模型喂文件”到“给模型接通一个长期维护的知识工程后端”,再到“让模型参与检索和决策”,这条线已经隐约可以看见。

对于普通用户,眼下最现实的做法是:

• 把真正需要长期积累的内容好好放进 NotebookLM,按主题建清晰的笔记本;

• 在 Gemini 里,把它当成一个可以“调用你自己知识库”的助手,用来做整理、生成和实验性的尝试;

• 保持一点点克制的期待:把它当成能力很强的合作者,而不是全知全能的替代者。

未来,当这些工具在“决策、路由、自评估”上变得更成熟时,我们今天花在整理和检索上的时间,很可能会越来越少,更多精力可以用在提问、判断和创造上。

---

说到这里,AI 的价值,应该是深入具体的业务场景,转化为实实在在的生产力。

无论你是想在 Cursor / VS Code 中加速代码开发编程,在 Obsidian / Notion 中构建私有知识库,还是通过 Chatbox、沉浸式翻译、Cherry Studio 优化日常工作流,以及制作宣传视频,生图创意设计,论文编撰,灵芽API 都能提供稳定靠谱的底层支撑。

作为国内领先的大模型 API 中转站,灵芽API 完美兼容 OpenAI 接口格式,支持官方直连,高稳定可靠,账单清晰透明。

作为国内领先的大模型 API 中转站,灵芽API 完美兼容 OpenAI 接口格式,支持官方直连,高稳定可靠,账单清晰透明。

如果你恰巧需要一个低成本、高可用的方案,让 Agent 和 AGI 真正融入你的项目与工作流,不妨从这里开始。

🔗 体验传送门: https://api.lingyaai.cn