AI竞赛下半场:谷歌大神Jeff Dean说,胜负手不再是参数

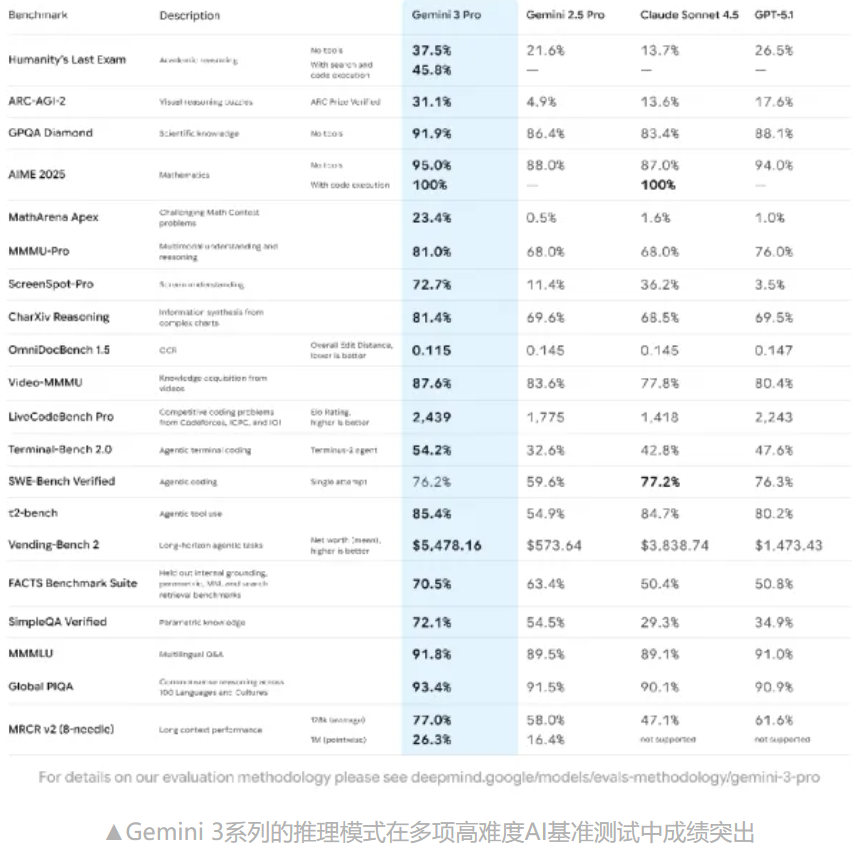

从“参数竞赛”回归“物理现实”——Jeff Dean眼中的AI下半场 当我们在谈论AI时,往往容易被Sam Altman(奥特曼)那种“星际之门”式的宏大叙事吸引,仿佛AGI(通用人工智能)明天就会敲响大门。 但如果你把目光转向硅谷的另一端,看向Google DeepMind的首席科学家Jeff Dean,你会发现一种截然不同的气场:冷静、精密、甚至带着一种工程师特有的“反骨”。 作为MapReduce和BigTable的缔造者,Jeff Dean不仅仅是写代码的人,他是那个给现代互联网铺设地基的人。而现在,当Transformer架构(正是出自Google)引爆全球后,这位Google内部的“终身院士(Senior Fellow)”正在思考的, 不是如何再堆砌一万亿参数,而是如何让这头吞噬算力的巨兽,在物理世界的法则中存活下来。 这就引出了一个关键判断:AI的下半场,正在从“参数竞赛”回归“物理现实”。 如果说英伟达的GPU是通用的“瑞士军刀”,那么Google的TPU就是一把为了特定任务锻造的“手术刀”。在最新的TPU v7中,最震撼的不是单点性能,而是规模效应。 想象一下,把9216颗芯片连成一个集群(Pod),这在工程上简直是疯狂的。但Jeff Dean关注的细节更有趣——精度取舍。TPU v7重点提升了FP4(低精度浮点)的性能。 这传递了一个信号:大模型不需要为了那个小数点后十几位的完美而浪费算力,它需要的是在模糊中寻找大概率的正确。这种对“计算宽容度”的利用,正在重塑芯片设计的底层逻辑。 这并非炫技,而是源于一种生存危机。 把时间拨回2013年,Jeff Dean在一张餐巾纸上算了一笔账:如果Google的1亿用户每天使用语音搜索3分钟,那么Google需要的CPU算力必须翻倍。这在经济上是不可行的——Google会因为买不起服务器而破产。 于是,TPU v1诞生了。它不是为了跑分,而是为了让Google活下去。这种**“专用硬件比通用硬件快30-70倍”**的效率胜利,确立了今天AI计算的核心:密集低精度线性代数。 Jeff Dean很清楚,硬件设计有滞后性(需要预判2.5-6年后的需求),今天我们看到的Gemini,其实是几年前硬件预判的结果。 很多人只看到了Google的芯片,却忽视了它最可怕的壁垒:垂直整合。 从最底层的TPU芯片,到XLA编译器,再到JAX框架,最后到Pathways系统和Gemini模型,Google握有全套钥匙。 这里必须提到Pathways系统。对于开发者来说,它制造了一个完美的“错觉”:你感觉自己只是在操作一台计算机。 但实际上,在这个“单一系统镜像”的界面之下,系统正在跨越城市、跨越物理集群,自动调度着两万个设备。 这种将复杂的分布式计算“平民化”的能力,才是Google区别于其他大厂的核心护城河。而通过Cloud TPU将这种能力对外租赁,Google完成了一个从内部造血到外部输血的商业闭环。 未来3-5年,AI的战局将在哪里?Jeff Dean给出的答案非常务实:从“训练”转向“推理”。 训练出一个极其聪明的模型固然重要,但如果每次提问都需要花费几美元的电费和几秒钟的等待,那它永远只能是实验室的玩具。 如果今天让Jeff Dean重画那张“餐巾纸”,他要解决的核心问题将是:如何实现低延迟、高能效、低成本的推理。 这也影响了Google对学术研究的资助模式。与其去炒作遥不可及的AGI,不如像当年资助TCP/IP或RISC架构那样,关注3-5年的中短期目标。 正是这些看似枯燥的基础研究,往往是商业爆发的前置条件。 在应用层,特别是医疗领域,Jeff Dean更是展现了极度的理性。 如果你认为AI医疗无法普及是因为模型不够聪明,那你就错了。真正的痛点是数据孤岛。 医院的数据格式混乱,且受限于隐私法规(Privacy)和合规性(Compliance),根本无法流动。 Google的解法不是打造一个“全知全能的医疗上帝”,而是联邦学习(Federated Learning)。 这是一种思路的逆转:既然数据不能出来,那就让算法进去。让模型在各家医院本地训练,只交换加密后的参数更新,不交换原始数据。这不是学术概念,而是落地的唯一解。 Jeff Dean的终极愿景很朴素:让每一次过往的临床决策,都能成为未来决策的参考系。 面对OpenAI的强势竞争,Google的策略也在调整。 你可能注意到了,Gemini的核心架构细节不再像当年的Transformer那样毫无保留地公开。这是**“核心秘方”的封闭**。 但在那些尚未验证的、早期的探索性领域,Google依然保持着学术界的实验性开放,利用社区力量试错。 而在产品发布节奏上,Google正在执行**“产品先行,论文殿后”**的策略。 看看Pixel手机上的“夜视模式”或“魔术橡皮擦”,都是先作为独家功能推向市场,建立壁垒,然后再通过SIGGRAPH等顶级会议发表论文。既赚了钱,又赢了名声,这才是老练的商业玩家。 归根结底,Jeff Dean眼中的AI下半场,是一场指数级的AI能力与线性的物理世界之间的博弈。 当模型参数撞上了电力的墙、数据的墙、法律的墙,那些只会谈论“奇点”的人将束手无策。 而AI的下一个黄金时代,将属于那些能解决系统成本、数据隐私、能效比这三大“非性感”问题的务实派。 Jeff Dean正在带领Google,从“模型层”的血腥厮杀中抽身,退回到他最擅长的“系统层”,准备进行一场降维打击。 聊了这么多,归根结底,科技还是得落到实处,有价值可用高效率提升才算数。 无论你是想在Chatbox、Cursor、Cherry Studio、沉浸式翻译,还是在 VS Code 里,Obsidian、Notion,知识库,封装自己的应用,对接业务等 , 灵芽API 都能做一个很好的“摆渡人”。 “开箱即用”,完美兼容 OpenAI 接口格式。 如果你也想让 AI 真正低成本地融入你的工作流,不妨试着从这里开始。 🔗 体验传送门: https://api.lingyaai.cn/

一、 算力底座:不仅仅是快,更是为了“生存”

二、 隐形的护城河:你以为操作的是一台电脑

三、 战略焦点转移:推理,还是推理

四、 医疗领域的“反常识”真相

五、 开放与封闭的辩证法

总结:系统工程师的回归