一文读懂AI 智能体中MCP、API与Function Call

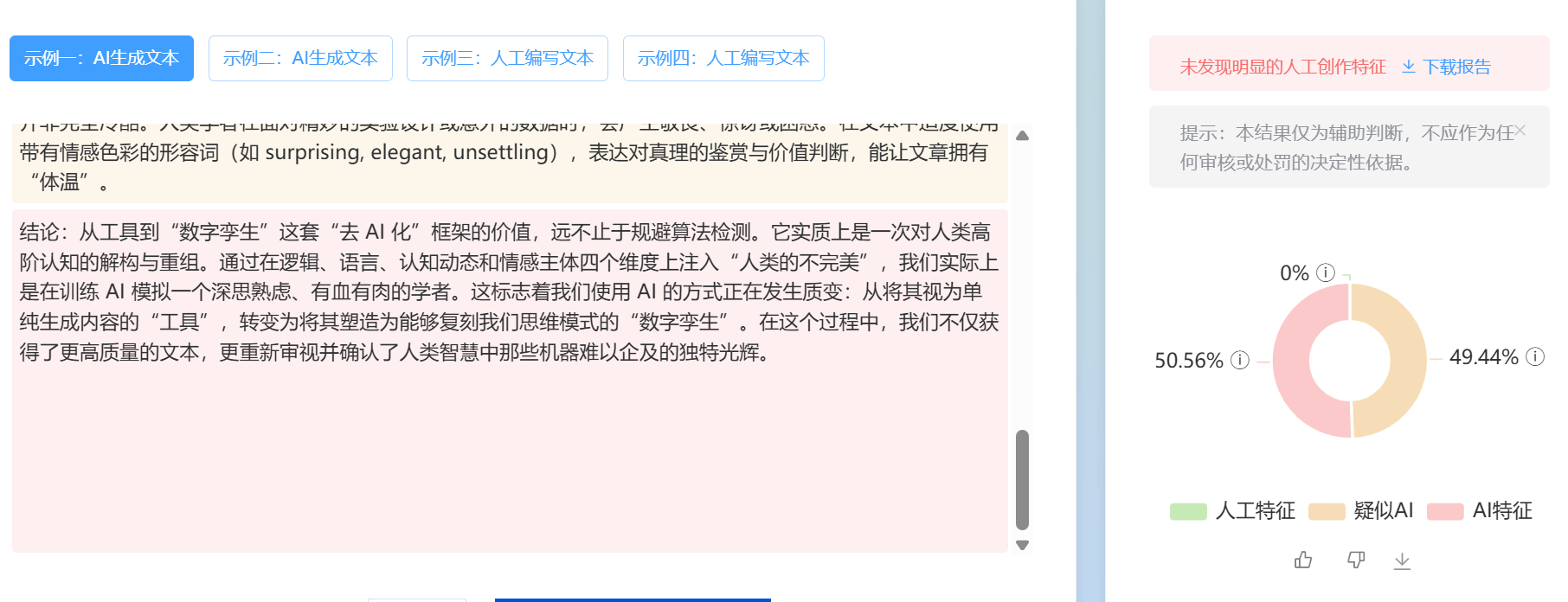

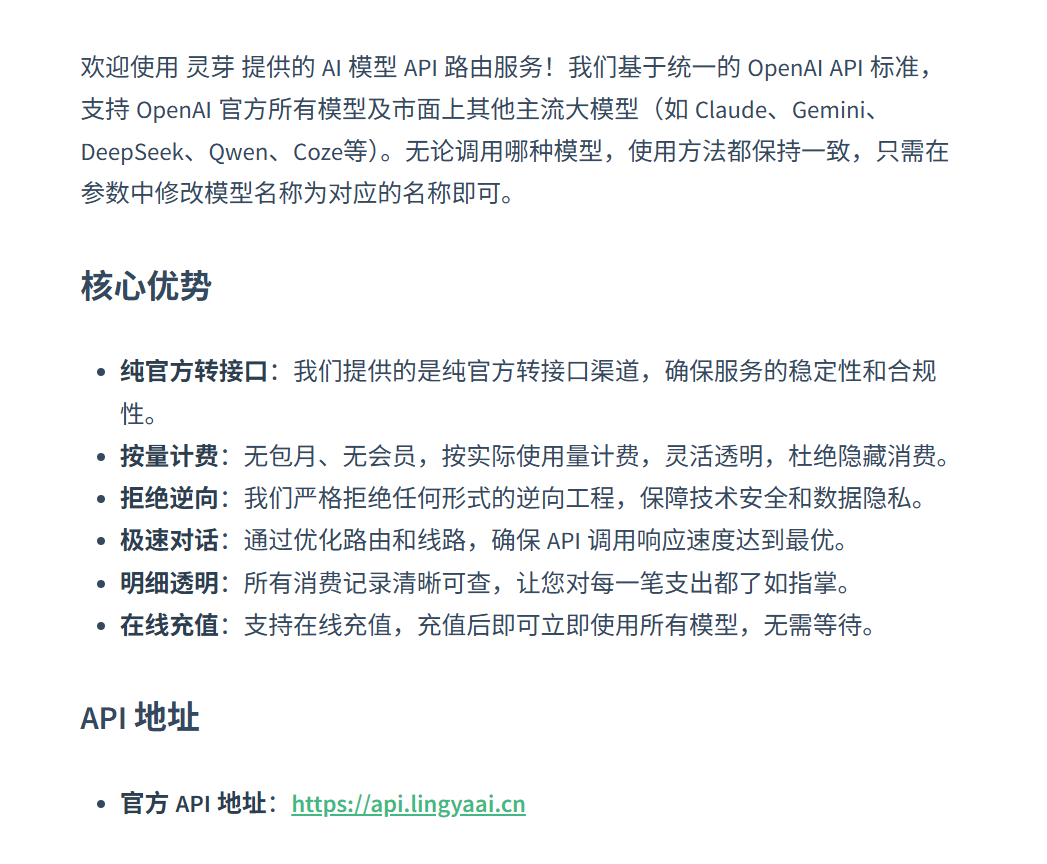

随着人工智能技术的飞速发展,大型语言模型(LLM)的能力边界已不再局限于文本生成。 为了让AI模型真正成为能执行任务的“AI Agent”,它必须能够与外部世界进行高效、安全的交互。这种交互的核心,便是API、Function Call和Model Context Protocol(MCP)这三大关键机制。 API、Function Call和MCP虽然都服务于模型与外部系统的交互,但它们的技术定位和设计理念有所不同。 API的本质是通用系统组件的通信标准。它定义了软件组件之间进行交互的规则和契约,并不特定于AI领域。 在AI系统中,API扮演着“数据与服务桥梁”的角色。无论是调用一个简单的天气查询服务、获取实时的地图数据,还是访问一个复杂的企业数据库,AI Agent都必须通过相应的API来实现。 可以说,API是AI Agent连接外部世界的基础设施。 Function Call是特定于LLM的机制,它允许模型在推理过程中,识别用户的意图并生成结构化的JSON输出,以调用预定义的外部函数或API。 这一机制由OpenAI在2023年6月首次推出(当时称为Function Calling),迅速成为主流。 它的核心优势在于将原本需要复杂的自然语言处理才能实现的“意图-行动”转换,简化为模型直接生成结构化数据(Schema化的JSON),极大地提高了调用的准确性和可靠性,并减少了模型的“幻觉”现象。 Model Context Protocol是Anthropic于2024年11月提出的一个开放标准,旨在统一LLM与外部数据源和工具之间的通信协议。 MCP的提出,是为了解决AI模型在企业级应用中面临的“数据孤岛”和安全挑战。它提供了一个标准化的接口,其核心特点在于: • 标准化通信:提供一致的通信接口,减少自定义集成的工作量。 • 安全性:通过特定的协议架构,使AI模型能够安全地访问和操作本地及远程数据,并且可以由Server端控制资源访问权限,降低敏感信息泄露的风险。 AI Agent要完成一个复杂任务,例如“查询明天上海的天气,并根据天气情况在日程表上提醒我是否需要带伞”,需要这三种机制的协同工作。 在AI Agent中,API是执行任何外部动作的基础手段。Agent对外部世界的任何访问——无论是获取数据还是触发操作——最终都需通过调用特定的API端点来完成。 例如,一个Agent要查询天气,其Python代码的底层逻辑必须是向第三方天气服务API发送一个HTTP请求,并解析返回的JSON数据。 Function Call解决了AI Agent**“何时以及如何”**调用API的问题。它作为一种高级抽象,简化了Agent的开发流程。 工作流程简述: 1. 用户请求:用户输入自然语言指令,如:“帮我查一下旧金山现在的气温。” 2. LLM决策:LLM根据预先提供的函数定义(Schema),判断需要调用名为 3. 生成指令:LLM生成结构化的JSON输出,例如: 4. 执行与返回:Agent框架捕获此JSON,调用实际的API,获取结果(例如 5. 模型总结:LLM接收API返回的原始数据,将其转化为用户友好的自然语言回复:“旧金山目前的气温是15摄氏度。” Function Call的关键优势在于其结构化输出能力,极大地降低了开发者处理复杂自然语言解析的复杂度,提高了Agent执行任务的准确率。 MCP是AI Agent与大量外部系统交互的高级协议。它将LLM、工具、数据和Prompt信息进行标准化、安全地连接。 核心概念: • MCP Hosts:通常是发起请求的LLM应用程序(如Claude Desktop应用)。 • MCP Servers:提供上下文、工具集和安全访问权限的中间层。它可以安全地访问本地或远程资源(如Google Drive、企业数据库)。 • MCP Clients:位于Host内部,与Server保持连接。 MCP的优势在于其统一性和安全性。通过Server的控制,敏感资源的安全访问得以标准化,工具调用不再需要为每一个LLM或应用定制,实现了高互操作性。对于需要长期维持上下文(Long-Context)和访问企业级数据源的应用,MCP提供了强大的架构支撑。 理解三者的核心差异,需从它们解决的问题和所处的层级来看。 层级关系: • API:是功能提供者,是 Agent 能否行动的基础。 • Function Call:是操作执行者,解决了**“怎么调用外部函数”**的问题。 • MCP:是资源协调者,解决了**“如何高效、安全地管理和连接大量外部工具与数据”**的问题。 三者共同构成了AI Agent与外部世界交互的完整系统。API提供基础功能,Function Call提供直接的操作能力,而MCP则提供了更高层次的智能协调能力,包括上下文管理和安全访问控制。 Function Call适用于简单、直接的外部系统调用,特点是任务明确、耦合度高、且调用逻辑相对独立。 • 示例:股票实时查询、路线规划、简单数据计算(如汇率换算)。在这些场景中,模型只需要生成一个结构化的 JSON 指令即可完成任务。 MCP适用于需要统一标准、安全敏感、或长期上下文的企业级应用。 • 示例: • 企业级应用:AI Agent需要安全访问员工的Google Drive文件、Slack聊天记录或GitHub代码库。 • 长期对话:在持续数小时或数天的复杂工作流中,MCP帮助Agent维持和管理复杂的上下文信息。 • 安全敏感应用:由于Server端控制资源访问,可以确保敏感信息无需暴露给LLM提供商,从而提供更高的隐私保护。 未来,AI Agent与外部世界的交互将朝着标准化与互操作性的方向发展。 MCP正成为连接AI Agent与外部系统的重要桥梁。它的开放标准设计意味着工具调用不再必须强依赖于特定LLM的Function Call实现,从而大大提升了AI生态的互操作性。随着MCP生态系统的快速发展,社区实现的Server将能够提供对文件系统、数据库、Web自动化等功能的丰富支持。 此外,由于MCP架构提供的安全模型,特别是在Server端控制资源访问权限的能力,将使得AI Agent在处理企业级、安全敏感的应用时更具优势,成为未来构建高效、安全、可扩展的AI Agent系统的关键技术。 API、Function Call 和 Model Context Protocol 是驱动现代AI Agent实现“感知”与“行动”的关键技术。 • API:提供基础通信能力。 • Function Call:简化了LLM调用外部函数的复杂性与可靠性。 • MCP:提供了更高层次的统一标准、互操作性与安全性。 对于开发者和技术分析师而言,清晰理解这三种机制的异同及其在不同应用场景中的取舍,是设计高效、安全、并具备高度自主性的AI Agent的必要前提。一、基本概念与技术源流

1. API (Application Programming Interface)

2. Function Call(函数调用)

3. Model Context Protocol (MCP)

二、在 AI Agent 中的作用与工作流程

1. API:交互的底层基石

2. Function Call:提升效率与可靠性的“翻译官”

get_current_weather的函数。{"name": "get_current_weather", "parameters": {"location": "San Francisco"}}。{"temperature": "15C"})。3. MCP:统一、安全与上下文的管理协议

三、三者的区别、层级与协作关系

特性 API (Application Programming Interface) Function Call MCP (Model Context Protocol) 解决的问题 通用系统组件如何通信。 LLM如何生成结构化指令来调用外部函数。 大量外部工具和数据源如何统一、安全地接入LLM。 技术层级 基础通信标准 (Level 1) LLM特定机制 (Level 2) 开放式通信协议/标准 (Level 3) 依赖性 无AI依赖,通用技术。 强耦合特定LLM的生成能力。 弱耦合LLM,旨在成为开放标准。 核心优势 提供基础功能和连接。 简化开发、提高调用准确性。 统一标准、高安全性、上下文管理。 四、具体应用场景与未来展望

1. Function Call 的典型应用场景

2. MCP 的典型应用场景

3. 发展趋势与未来展望

结论