“模型即 Agent”时代到来:月之暗面 Kimi K2 Thinking 引爆 AI 社区,被称为『另一个 DeepSeek 时刻』

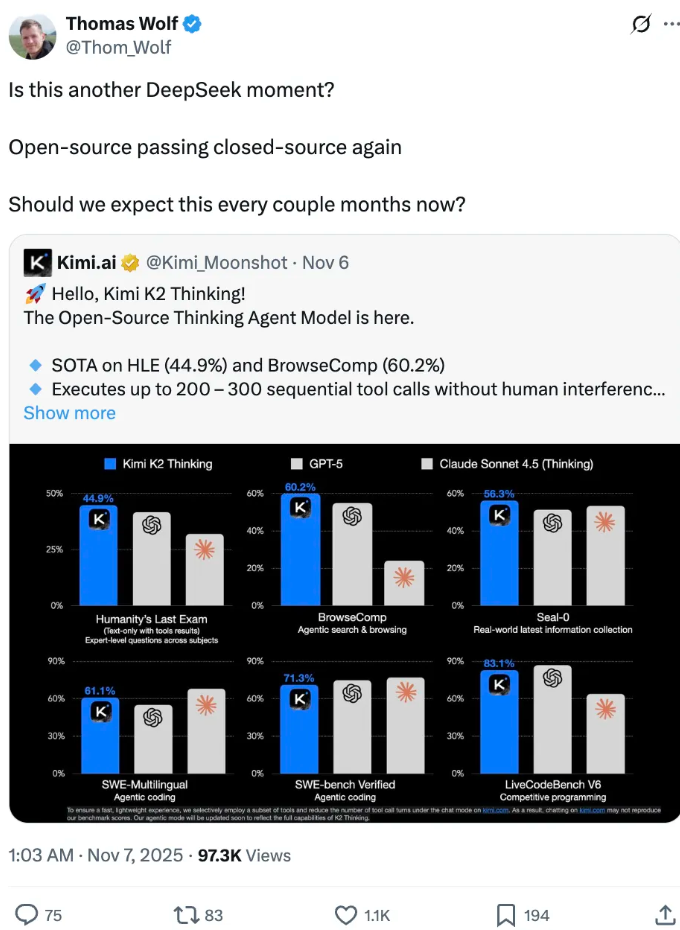

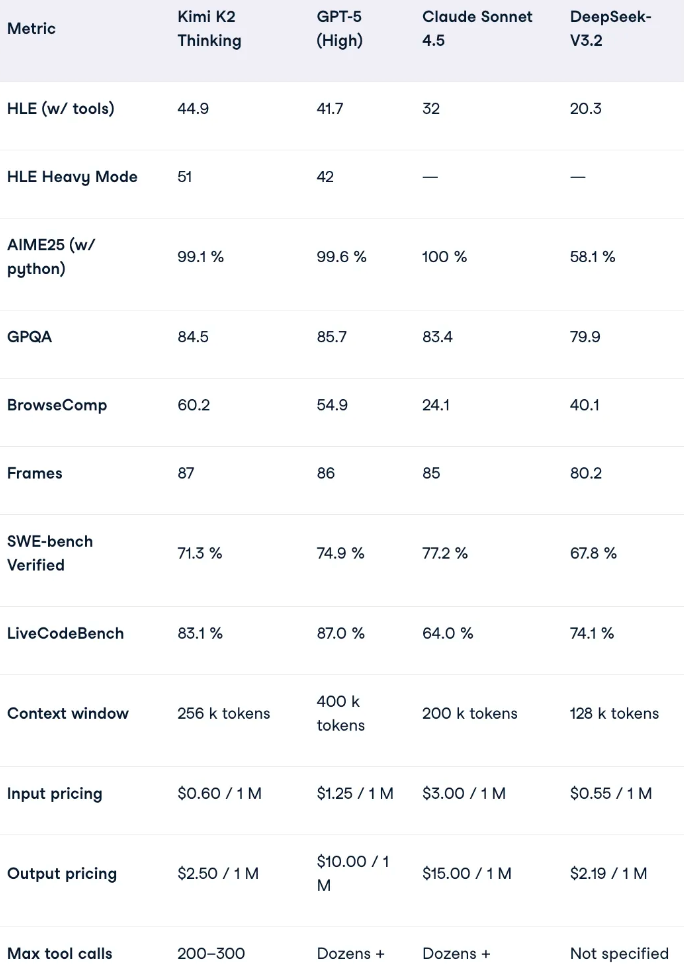

上周,月之暗面(Moonshot AI)正式发布并开源了 Kimi K2 Thinking(K2 增强版),这是一个以「模型即 Agent」为核心理念的新型大模型版本。短短数天内,它就在开源与 AI 社区掀起了热潮,被许多业内人士称作“另一个 DeepSeek 时刻”。 K2 Thinking 的发布不仅是一次版本迭代,更像是一次理念上的跃迁——它不再只是一个语言模型,而是尝试向具备主动推理与执行能力的智能体(Agent)进化。 事件发布后,Hugging Face 联合创始人 Thomas Wolf 公开表达了惊讶与赞赏;Reddit 上的 AMA(Ask Me Anything)活动更是将讨论热度推向顶点。 短短几天内,社区的情绪从“好奇”演变为“兴奋”,这标志着开源阵营再次对闭源大模型格局发起了冲击。 根据公开测试数据,K2 Thinking 在 HLE、BrowseComp、AIME25 等多项国际评测中表现亮眼,整体成绩超越 GPT‑5 与 Claude 4.5,在数学推理、信息检索与综合推理强度等关键维度位列前茅。 这意味着,在开源模型与闭源巨头之间的技术鸿沟,正在被显著缩小。 K2 Thinking 建立在 Kimi K2 的基础之上,同时继承并扩展了 DeepSeek R1 的架构思想。 • 万亿级 MoE(混合专家)架构 • 原生 INT4 精度与量化感知训练 • 256k 超长上下文 • 稳定的连续工具调用能力 K2 Thinking 不仅仅是一个更聪明的模型,更是一次“模型角色定义的重构”——模型不再被动响应,而能主动规划、执行和修正任务,实现真正意义上的「模型即 Agent」。 在 AMA 中,团队针对关键问题做出了详实回应,为外界揭开了 K2 Thinking 背后的诸多技术细节。 所谓 KDA(Kimi Delta Attention),是一种用“增量更新 + 门控机制”取代传统全连接注意力的新式架构。 下代模型 K3 已进入概念阶段,但发布时间尚未确定。 Moonshot 确认正在开发视觉语言模型,未来版本将支持多模态交互。 外界流传的“460 万美元训练成本”并非官方数据。团队澄清,成本更难以量化,真正的大头来自研究与实验周期,而非单一训练花费。 有用户反馈 K2 Thinking 推理速度偏慢(约 5–10 倍差距)。 部分用户认为模型输出过于“干净、平淡”。 K2 Thinking 从设计阶段就以“Agent 思维”为核心:它能主动推理、规划并连续执行任务。 其关键机制是 Test‑Time Scaling(测试时扩展): • 通过延长思维 token 来加深推理深度; • 通过增加工具调用次数来拓展执行空间。 K2 Thinking 在多项评测中表现出类人专家式的“反省‑修正‑验证”节奏。 在 SWE‑Bench、Terminal‑Bench 等评测中,K2 Thinking 的综合得分处于开源模型第一梯队。 在 BrowseComp 测试中,K2 展现了研究员般的思考节奏: 得益于深层调优,K2 Thinking 的文本组织更平衡: 采用极致的 INT4 精度 与 量化感知训练(QAT) 策略,放弃 FP8。 KDA 的核心是“只更新变化部分”,大幅减少了 KV 缓存约 75%。 K2 Thinking 是一个“平衡美学的产物”: • 架构(KDA) 提升思维稳定度; • 量化(INT4/QAT) 降低资源消耗; • 调度(Test‑Time Scaling) 实现智能推理的灵活性。 这也代表了一个新的行业趋势——从堆尺寸到堆智慧:模型不一定更大,但必须更聪明、更经济、更会思考。 K2 Thinking 的发布,标志着月之暗面重新回到了全球舞台中央。 未来,Moonshot 将重点落在以下几方面: • 优化 KDA 机制,进一步提升 token 效率; • 推出视觉‑语言(VLM)多模态能力; • 在对话生成中实现更“真实”的人类语气; • 布局 K3 阶段的架构演进与规模扩展。 从事件、机制到行业意义,K2 Thinking 展示的不仅是性能飞跃,更是一种范式转变: 模型不再只是回答问题的工具,而开始具备主动思考、规划与执行的能力。 在 AI 迈向 Agent 化的进化路上,Moonshot 用 K2 Thinking 向世界抛出了一个明确信号——一、事件背景与行业反响

1.1 事件概述

1.2 行业内的反响

创始团队——杨植麟、周昕宇、吴育昕——首次集中回应外界提问,议题从模型架构、训练策略、视觉模型计划到未来的 K3 体系,几乎覆盖了每一个关心的焦点。二、K2 Thinking 的整体表现与突破

2.1 全球基准测评成绩

2.2 技术定位

它的核心特征包括:三、Reddit AMA 的核心回应摘要

3.1 关于 KDA 注意力机制

它有效解决了 MoE 模型在长上下文处理时出现的一致性下降与 KV 缓存膨胀问题。

杨植麟确认,这一思路“极有可能在 K3 中延续下去”,团队也在开发进一步优化版本。3.2 K3 计划

杨植麟打趣道:“在 OpenAI 的万亿美元数据中心建成之前吧。”

这句玩笑背后,其实暗示出 Moonshot 的节奏——注重方法完备度,而非竞速式发版。3.3 视觉语言模型(VLM)

3.4 训练成本与争议

3.5 性能与速度平衡

对此,杨植麟回应:模型采用“长链式推理”机制,其设计目标是思维深度优先。

不过团队也在持续优化 token 效率,寻找“深度思维”与“执行速度”的平衡点。3.6 关于 “slop” 现象与文风优化

官方回应称,减少 “slop” 是行业长期挑战,未来版本将在情绪表达、人性化语气上逐步开放,减少过度过滤。四、能力与结构深析:从思维链到 Agent 智能

4.1 架构理念:以 Agent 为中心

模型可在单次会话中触发 200–300 次连续工具调用,保持长期逻辑一致。4.2 推理能力的飞跃

在 HLE、BrowseComp、𝜏²‑Bench 等测试中,其思考链条稳定而细腻,首次提出了“稳定思维深度(Stable Reasoning Depth)”的指标,用于衡量模型在长链逻辑中的一致性。4.3 编程与工程能力

它不仅能生成多语言代码,还能理解需求、验证输出,并形成自我修正闭环——具备了“懂工程”的智能体特质。4.4 网页推理与智能搜索

循环执行“思考—搜索—阅读—再思考”,能够在信息不完全的场景下自主修正方向并得出可靠结论。

这标志着模型具备了“研究型 Agent”的雏形。4.5 通用智能与写作表现

无论是学术性论述,还是创意写作,都能在逻辑与情感之间取得自然流畅的风格。五、底层创新:量化、注意力与工程平衡

5.1 原生 INT4 量化

结果是推理速度提升近 2 倍,显存占用显著下降,同时保持高精度稳定性。

这使得 K2 Thinking 在消费级 GPU 上也具备可行的运行条件。5.2 注意力机制革新:KDA

门控机制确保多专家之间的上下文连续,从而在长序列推理中实现稳定语义一致性。5.3 工程整合思路

六、行业意义与未来展望

6.1 技术与品牌层面

它不仅缓解了开放生态的焦虑,也为开源社区带来了信心——证明了无需天价资源,也能做出世界级水平的模型。6.2 未来路线

✅ 结语

真正的智能,不在于更高的参数量,而在于让机器学会思考。